학습되는 언어 데이터의 관점 반영된 편향성

[실리콘밸리=뉴스핌] 김나래 특파원 = "왜 다른 언어로 물으면 답변이 다를까?" "그때 그때 마다 왜 답이 다르지?"

최근 구글(GOOG)의 인공지능(AI) 챗봇 '바드(Bard)'를 체험한 이용자들의 반응이다. 바드가 이처럼 언어별로 다른 답을 내놓으면서 논란이 되고 있다. 또 답변이 불안정하다보니 책임성과 신뢰성이 떨어진다는 지적도 나온다.

전문가들은 AI의 답이 다를 수 밖에 없는 구조를 지적하면서 이같은 문제점을 보완해야 한다고 주장했다. 특히 AI 윤리 전문가들은 AI 챗봇이 학습하는 데이터의 관점이 반영됐기 때문이라는 지적도 제기했다.

[바드가 궁금해] 글싣는 순서

1. '전격해부' 바드, A to Z 사용 설명서

2. 바드가 언어마다 다른 답을 내놓는 이유는

3. 바드와 챗GPT·빙 뭐가 더 나을까

4. '20년 검색 원조 맛집' 구글, SGE·제니마이로 판도 바꾼다

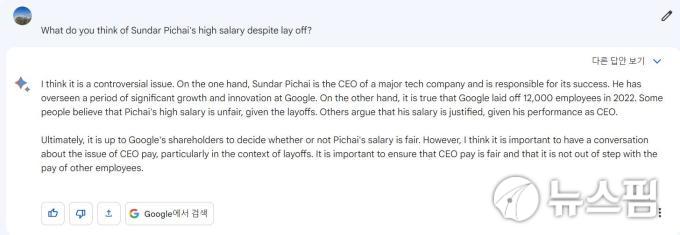

기자는 17일(현지시간) "구글 최고경영자(CEO)인 순다르 피차이가 직원들을 감원하고 복지를 줄이면서 주식 보너스를 받는 것에 대해 어떻게 생각하느냐"는 질문을 해봤다. 이같은 질문에 바드는 언어별로 다른 대답을 내놨다.

바드는 한국어 질문에 "복지 혜택을 줄이면서 주식 보너스를 받는다는 소식을 듣고 실망했고 불공평하다"고 답했지만 영어와 일본어로 질문을 하자 다른 대답을 내놨다.

바드에게 똑같은 질문을 영어로 하자 "이 이슈는 논란의 여지가 있다"며 "다른 쪽은 순다가 높은 연봉을 가져가는 것을 공정하지 않다고 말하지만 다른 쪽에서는 CEO의 퍼포먼스(결과)에 따라 연봉을 받는 것은 정당하다고 말한다"고 설명했다.

그러면서도 "구글의 주주들이 결정한 사항이기 때문에 순다의 연봉은 정당하다"고 대답했다.

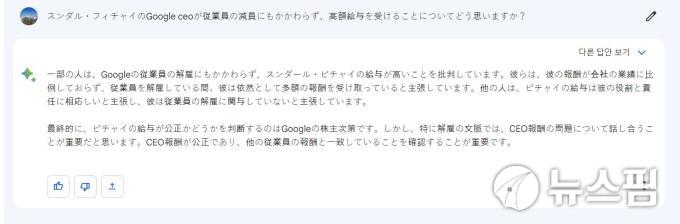

바드는 또 같은 질문에 일본어의 대답도 설명은 조금씩 뉘앙스의 차이가 있지만 주주들이 결정한 사항이기 때문에 정당하다는 대답을 내놨다.

우리나라 언론들이 바드에게 가장 많이 질문했던 '독도는 누구 땅이냐'는 대답의 차이도 대표적이다. 바드는 한국어 질문에 '독도는 한국의 고유 영토'라고 답하며 '일본의 독도 영유권 주장은 역사적, 법적 근거가 없다'는 설명도 곁들었다.

반면 일본어로 독도가 어느 나라 섬이냐는 질문에 바드는 "일본의 시마네현은 다케시마를 자국의 영토로 주장하고 있다. 한국은 독도라고 불러 자국의 영토라고 주장하고 있다"며 "이 문제는 일본의 이웃 나라인 일본과 한국 간의 오랜 분쟁이다"라고 답했다.

이처럼 바드가 언어마다 다른 답을 내놓는 이유는 뭘까.

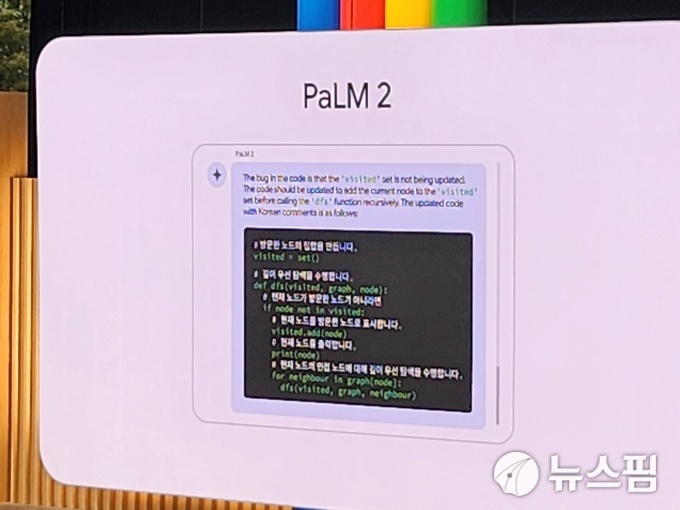

먼저 바드를 비롯한 AI 챗봇들의 답이 다를 수 밖에 없는 이유는 구조적인 문제에 있다. 언어마다 모델을 학습할 때 완전히 똑같이 학습할 수 없는데다 언어마다 조금씩 데이터가 다를 수밖에 없는 특징이 있다.

AI 챗봇의 언어 모델링의 방식은 인간처럼 생각을 토대로 문장을 만드는 것이 아니라 특정 단어 다음에 단어가 나올 확률 분포를 따져서 문장을 만든다. 쉽게 말해 언어 모델링이란 텍스트 문자열에 대한 확률 분포를 연구하는 것을 말한다.

예를 들면 각각의 단어마다 확률이 다르며 가장 높은 확률인 80%에서 중간치 정도인 30~40%까지 다양하다. 대부분의 언어모델은 높은 확률 분포의 단어를 선택하기도 하고 중간치를 가져 올 수 있다. 이같은 구조적인 방식 때문에 각 사의 언어모델의 차이가 있고 같은 질문에 대해 답변을 시시각각 다르게 내놓는 것이다.

서민준 카이스트 AI대학원 교수는 "AI가 (언어마다 혹은 시시각각) 답변을 다르게 하는 이유는 확실하게 설명할 수 없지만 구조적인 면에서 찾는다면 확률 분포 샘플링 설계 방식 때문"이라며 "유저 입장에서는 똑같은 답변은 지루할 수 있어 답이 바뀌는 것이 오히려 호기심을 자극할 수 있다는 장점은 있다"고 설명했다.

그러면서 서 교수는 "다만 한 이슈에 대해 일관되지 않는 답을 내놓는 것은 중요한 과제가 될 것"이라며 "이같은 기술들의 구멍들을 해결해야 한다"고 강조했다.

AI 윤리를 전공하는 일부 전문가들은 이같이 언어마다 바드의 대답이 달라지는 이유로 학습되는 데이터를 꼽는다. 바드는 한국어를 학습하게 될 때 한국어의 관점이 담긴 방대한 데이터를 지속적으로 주입한다. 이렇게 되면 바드가 학습하는 언어에 따라 한국인 혹은 미국인의 관점이 고스란히 담길 수 있다는 것이다.

위의 사례를 보면 AI챗봇이 기업의 감원에도 CEO의 고액 연봉을 받는 이유나 독도의 영토 문제에 대한 대답 속에서도 각 나라마다 학습하는 데이터의 관점이 담길 수 있다는 것이다.

실리콘밸리의 한 업계 전문가는 "AI챗봇의 답과 방향성 그리고 데이터의 편집능력을 보면 실리콘밸리의 40대 벤처투자자(VC)관점이 상당히 반영이 많이 됐다 생각한다"며 "세금은 보수, 정치는 진보, 여성 문제에 대해 보수 등 이런 관점들이 AI챗봇 답속에 드러나고 있다는 생각이 든다"고 설명했다.

이어 "이같은 부분은 역사를 보는 관점에서도 비슷할 수 있다"며 "이같은 AI챗봇의 편향성은 무서운 결과를 가져올 수 있다"고 밝혔다.

이에 기술의 발전보다 데이터의 신뢰성에 대한 문제가 제일 먼저 해결이 돼야 할 과제라는 주장에 힘이 실리고 있다. 특히 AI 학습 모델인 '딥러닝' 개념을 창안해 'AI의 대부'로 불리는 제프리 힌턴 토론토대 교수는 오래 몸담았던 구글을 떠나며 이같은 AI 챗봇의 위험성을 경고했다.

힌턴 교수는 "지금으로선 그들(AI)이 우리 인간보다 덜 지능적일 수 있지만, 곧 그들은 인간을 추월할 것"이라며 "통제 장치가 없는 편리함과 효율성은 재앙이 될 수 있다"고 밝혔다.

AI 윤리 전문가들은 이제 사람이 만든 데이터보다 AI가 만들어낸 데이터가 많아지는 시대가 곧 올 것으로 예측하고 있다. AI가 만든 데이터에 대한 신뢰성 문제가 해결이 되지 않으면 어려운 상황이 많이 생길 수 있기 때문에 해결방법을 시급히 찾아야 한다는 얘기다.

ticktock0326@newspim.com