자료 처리 및 영상 학습 등 다양한 분야 활용 기대

기업들의 신기술 개발은 지속가능한 경영의 핵심입니다. 이 순간에도 수많은 기업들은 신기술 개발에 여념이 없습니다. 기술 진화는 결국 인간 삶을 바꿀 혁신적인 제품 탄생을 의미합니다. 기술을 알면 우리 일상의 미래를 점쳐볼 수 있습니다. 각종 미디어에 등장하지만 독자들에게 아직은 낯선 기술 용어들. 그래서 뉴스핌에서는 'Tech 스토리'라는 고정 꼭지를 만들었습니다. 산업부 기자들이 매주 일요일마다 기업들의 '힙(hip)' 한 기술 이야기를 술술~ 풀어 독자들에게 전달합니다.

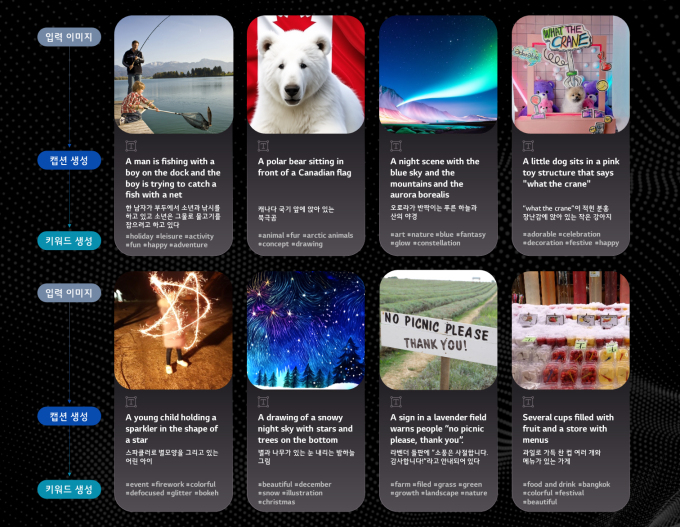

[서울=뉴스핌] 이지용 기자 = "아이가 그물로 물고기를 잡으려고 하고 있네요".

이제 인공지능(AI)이 텍스트뿐만 아니라 사진과 그림 등의 이미지까지 스스로 설명할 수 있는 시대가 왔습니다. AI는 처음 접하는 이미지도 사람처럼 이해하고 설명할 수 있습니다.

LG가 최근 세계 최대 컴퓨터 비전학회 'CVPR 2023'에서 생성형 AI 상용화 서비스인 '캡셔닝 AI'를 선보였습니다. 이 캡셔닝 AI는 처음 보는 이미지를 자연어로 설명할 수 있는 AI로 이미지와 텍스트를 기반으로 배경과 인물, 행동 등 이미지의 다양한 요소를 인식해 설명하는 기술입니다. 어떤 이미지든 입력만 하면 그 이미지에 어떤 의미가 담겨 있는지, 어떤 상황이 일어나고 있는지 파악할 수 있는 것입니다.

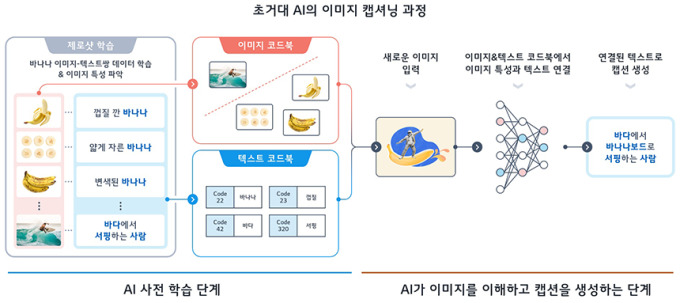

LG는 캡셔닝 AI에 '제로샷 이미지 캡셔닝' 기술을 활용했습니다. 제로샷(Zero-shot)은 말 그대로 '추가적인 데이터가 없다'는 뜻을 가지고 있습니다. 제로샷은 사람의 시각 인지 능력처럼 기존의 메타데이터를 기반으로 스스로 이해하고 유추한 결과를 텍스트로 이끌어내는 것입니다.

예를 들어, '껍질 깐 바나나', '얇게 자른 바나나', '변색된 바나나', '바다에서 서핑하는 사람'이라는 기존 이미지가 있다면 이들을 비슷한 형태의 이미지끼리 분류해 이미지 코드북이라는 데이터 모음집에 넣습니다. 동시에 '바나나'와 '껍질', '사람', '서핑' 등의 텍스트는 다시 별도의 텍스트 코드북에 포함시킵니다. 이 때 각각의 텍스트를 'Code 22', 'Code 23' 등으로 숫자를 붙여 코드화합니다. 이를 AI 사전 학습 단계라고 부릅니다.

그 후 사용자가 '바다에서 바나나보드로 서핑하는 사람'의 의미지를 입력하면 캡셔닝 AI가 각각의 이미지·텍스트 코드북에서 '바나나'와 '사람'이라는 이미지의 특성과 텍스트(코드)를 연결시켜 이미지 설명을 담은 캡션을 생성합니다.

앞으로 이 캡셔닝 AI는 다양한 분야에서 활용될 전망입니다. LG는 캡셔닝 AI를 통해 평균 문장 5개와 키워드 10개를 10초 안에 생성할 수 있도록 했습니다. 이미지 범위를 1만 장으로 넓히면 2일 이내에 이미지 캡셔닝 작업을 끝낼 수 있을 정도로 빠릅니다. 많은 기업들은 캡셔닝 AI를 활용해 이미지 관련 처리 효율성 및 생산성을 높일 수 있을 것입니다.

교육 분야에서는 영상 학습을 요약해 학생들이 어려운 교과 내용을 쉽게 이해할 수 있도록 도울 수 있습니다.

캡셔닝 AI가 시각장애인들에게는 눈 앞의 보도 상황을 음성화한 '길 안내 서비스'가 될 수 있습니다. 이와 함께 자율주행자동차 주행 시, 도로 위의 물체가 사람인지, 동물인지 판단해 자율주행 사고 발생률을 크게 줄일 수 있을 것이라는 전망도 나오고 있습니다. 캡셔닝 AI로 우리 삶의 모습이 크게 바뀔 수 있는 것입니다.

김승환 LG AI 연구원 비전랩장은 "생성형 AI뿐 아니라 인간 수준으로 환경까지 인식하는 AI로 퀀텀 점프할 수 있는 가능성을 확인했다"고 말했습니다. 이어 "영상 이해의 핵심 기술이자 기반 기술인 이미지 캡셔닝에 대해 전 세계 AI 연구자들과 함께 논의해 기술 개발에 총력을 다할 것"이라고 강조했습니다.

leeiy5222@newspim.com